摘要:负载均衡是一种网络技术,旨在优化网络性能并增强系统的可靠性和可扩展性。它通过分散网络负载,确保所有服务器都能均衡地处理请求。负载均衡的实现方式包括DNS负载均衡、硬件负载均衡器、软件负载均衡等。其核心原理包括分析网络流量和服务器负载情况,通过算法将请求分发到最合适的服务器,以实现高效资源利用和最优的用户体验。

本文目录导读:

随着互联网技术的不断发展,服务器负载均衡已成为大规模分布式系统中的重要技术之一,负载均衡旨在优化网络性能,提高服务器的处理效率,确保服务的高可用性,本文将详细介绍负载均衡的原理及实现方法。

负载均衡原理

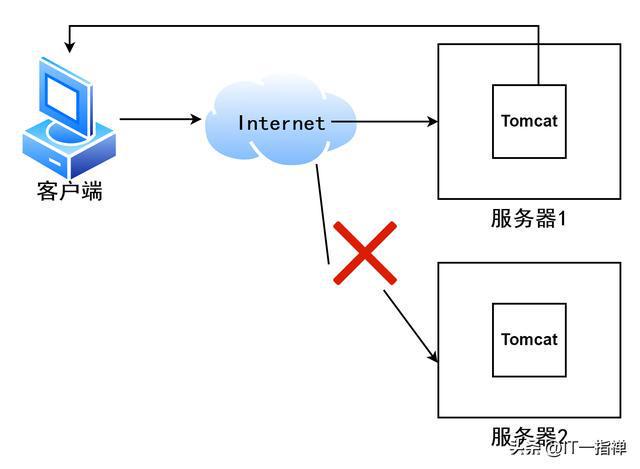

负载均衡的基本原理是通过将网络请求分散到多个服务器上来实现负载的均衡分配,其核心思想是将负载(如网络请求、任务等)在多个处理单元(如服务器、计算机集群等)之间进行分配,以实现系统的最佳性能,负载均衡有助于提高系统的吞吐量、加速响应时间,并避免单点故障导致的服务中断。

负载均衡通常基于以下策略进行实现:

1、轮询(Round Robin):按顺序将请求分配给每个服务器,确保每个服务器都有机会处理请求。

2、权重轮询:根据服务器的性能或其他指标分配不同的权重,按权重比例分配请求。

3、最少连接(Least Connections):将请求分配给当前连接数最少的服务器。

4、IP哈希:根据客户端IP进行哈希计算,将相同的IP请求分配给同一台服务器。

5、响应时间优先:根据服务器的响应时间进行排序,将请求分配给响应时间较短的服务器。

负载均衡的实现

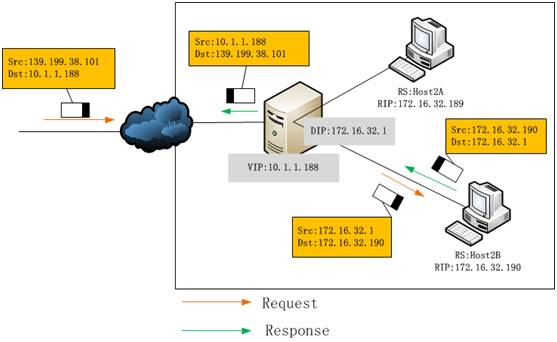

负载均衡的实现通常涉及硬件和软件两个方面,以下是常见的实现方式:

1、硬件负载均衡器:硬件负载均衡器是一种专门的设备,负责接收客户端的请求并将其转发到服务器,常见的硬件负载均衡器有F5 Big-IP、NetScaler等,这些设备通常具有较高的性能和可靠性,适用于大型网络环境。

2、软件负载均衡:软件负载均衡通过部署在服务器上的负载均衡软件来实现,常见的软件负载均衡解决方案有Nginx、HAProxy等,这些软件可以根据预设的负载均衡策略,将请求转发给合适的服务器。

3、云服务提供商的负载均衡服务:许多云服务提供商如AWS、阿里云等提供了负载均衡服务,这些服务可以自动管理流量的分配,提供弹性扩展和高度可用性。

负载均衡技术的进阶应用

随着微服务、容器化等技术的兴起,负载均衡技术也在不断发展,以下是一些进阶应用:

1、微服务负载均衡:在微服务架构中,服务间的调用非常频繁,微服务负载均衡显得尤为重要,常见的微服务负载均衡策略有客户端负载均衡和服务端负载均衡。

2、容器化环境下的负载均衡:容器化环境(如Docker、Kubernetes等)为负载均衡提供了更多的可能性,通过Kubernetes的Ingress资源或其他容器编排工具,可以轻松实现容器化环境的负载均衡。

3、动态负载均衡:传统的静态负载均衡策略在某些场景下可能无法满足需求,动态负载均衡能够根据实时负载情况调整资源分配,以实现更优的性能。

负载均衡是优化网络性能和提升服务器处理效率的关键技术,本文介绍了负载均衡的基本原理、常见策略以及实现方式,在实际应用中,需要根据具体的场景和需求选择合适的负载均衡策略和实现方式,随着技术的不断发展,负载均衡技术将在更多领域得到应用,为构建高性能、高可用的系统提供有力支持。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号

还没有评论,来说两句吧...